Люди не можуть протистояти фейкам

Використання технологій штучного інтелекту перетворюється на проблему гігантських масштабів, наслідки якої поки навіть складно уявити.

«Насправді йдеться про банальну неспроможність протистояти фейкам, через що люди обиратимуть одну з можливих моделей поведінки: вірити усьому; не вірити нічому; вірити лише тому, у що хочеться вірити (що підкріплює раніші упередження). Всі три підходи контрпродуктивні», - таку «передмову» написав до допису відомої української правозахисниці Олександри Матвійчук викладач і підприємець, візіонер Валерій Пекар. Нижче публікуємо власне допис очільниці організації, яка отримала у 2022 році Нобелівську премію миру.

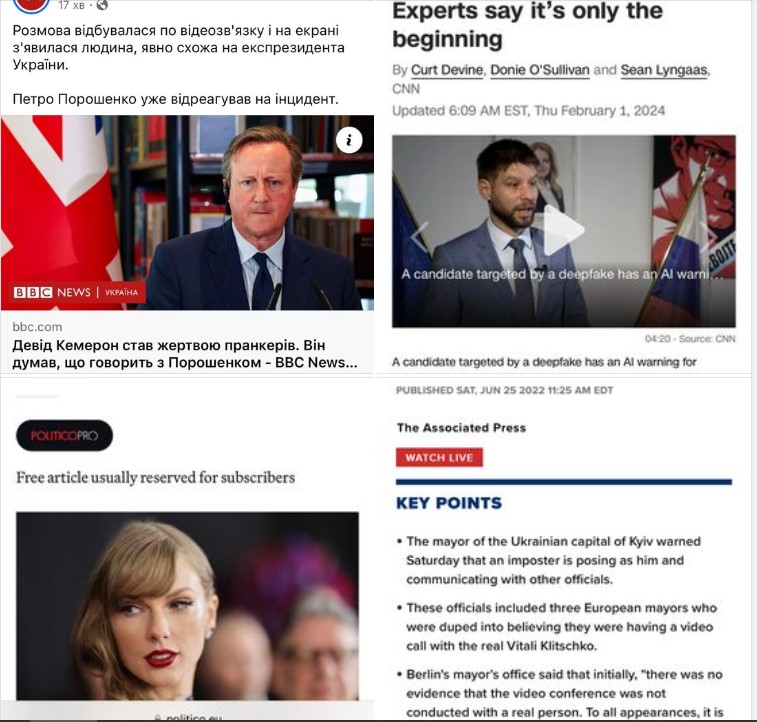

Історія із розмовою по відеозвʼязку із ніби-то Петром Порошенко та міністром закордонних справ Британії глибша, ніж здається.

У травні я виступала в американському університеті Берклі, який відомий кожному osint розслідувачу відкритих джерел, своїм «протоколом Берклі». Мені пощастило відвідати лекцію відомого у світі дослідника діпфейків. Давно хотіла поділитися бодай дечим із почутого, бо зовсім скоро це стане частиною нашого повсякденного життя. Далі лонгрід із прикладами та висновком.

Почну відразу із проблеми - у нашому світі правда програє брехні. Раніше над цим працювали політехнологи, але тепер створення альтернативної реальності доступні звичайній людині, і більше не прерогатива виключно держави чи великого бізнесу. Отже, кілька прикладів.

Від тексту до фото

Вже зараз є застосунки, які дозволяють перевести текст у фото. Інтернет заполонили фейкові фото цивільних нібито після бомбардувань у Газі (при тому, що реальні фото і так страшні). Поки ще на фейкових фото при бажанні можна побачити нестиковки, як-от, шість пальців на руці чи викривлені тіні. Але вже зовсім скоро вийдуть допрацьовані версії застосунків, де ці недоліки будуть враховані.

Копіювання голосу

Достатньо знайти в інтернеті буквально 15 секунд запису вашого голосу і застосунок змусить вас «озвучити» усе, що захоче замовник. Як показують дослідження, навіть ви самі не зможете розрізнити де ви говорите, а де вас озвучує AI. Це значить, що вам може подзвонити ваш найближчий друг і попросити скинути гроші, відправити документи, розказати якусь інформацію – і ви це зробите.

Від фото до відео у режимі реального часу

Маючи одне ваше фото, програма може зробити відео у режимі реального часу. Ви просто стаєте перед вебкамерою, і обрана вами за одним фото людина робить усе, що ви в цей час робите – посміхається, насуплюється, жестикулює. Нам це демонстрували наочно. Під час презентації було весело. Після - не дуже.

Від тексту до відео

Вихід застосунку для масового споживача очікується вже наступного року. Нам показали текст із описом японського ярмарку, який вкриває цвіт сакури. А потім відео, де цей текст ожив. На галасливому ярмарку ходили та скуповувалися люди. Сакури були прекрасні, і виглядало досить реалістично. Цікаво, як це вдарить по кіноіндустрії, адже для цих відео не потрібні актори, декорації чи великі бюджети.

Від фото до відео

Застосунок, який може це робити, теж очікується наступного року. Ви просто прописуєте, що людина на фото/картинці має сказати чи зробити – і вуа-ля. Нам показували приклад із картиною Мони Лізи. Оскільки я раніше ніколи не чула, як «говорить» Мона Ліза, то тепер я знаю, який у неї міг би теоретично бути голос.

Усі наявні зараз застосунки коштують від 5 до 50 доларів на місяць. Але якщо вам лінь розбиратися самостійно, то фейкові фото, відео чи аудіо вам зможуть зробити за 20 доларів чи дорожче численні акаунти, які відкрито, а не в darknet, пропонують такі послуги.

А тепер кілька прикладів застосування. Нам спеціально демонстрували різні сфери – вибори, виробництво сексуального контенту без згоди людини, національна безпека, кіберзагрози, шахрайство, недобросовісна бізнес-конкуренція, дезинформаційні кампанії, міжнародні відносини, війни, наукові дослідження.

На виборах президента Словаччини фейкове відео проєвропейського кандидата стало вірусним за два дні до голосування, і складно сказати, наскільки це вплинуло на перемогу кандидата із симпатіями до росії.

Викладач розказав історію, коли відпочиваючи на пляжі отримав дзвінок із Білого Дому. Його попросили дати оцінку справжності фото із нібито спробою атаки на Пентагон. І кількох хвилин, поки він повертався до свого компа, вистачило, щоб просіла фондова біржа, і несправжнє фото спричинило справжні збитки.

Співачка Тейлор Свіфт через суд зобов’язала видалити із інтернету створені AI її оголені фото. Але якщо ви не Тейлор Свіфт, то як захистити власну дитину, над якою вирішив посміятися однокласник у школі, буде зробити не в міру складніше. До всього все, що завантажили в мережу, там лишається (або буде багато коштувати, щоб приховати інформацію від спроб пошуку).

Загалом, робота із діпфейками спричинила до того, що наш викладач, коли говорив онлайн із Бараком Обамою, ловив себе на думці, що так і не впевнений, що говорить із справжнім президентом, а не його цифровою копією. Ця небезпека актуальна для мерів європейських міст, із якими спілкувався по зуму нібито мер Києва Кличко. Вони тільки в ході розмови здогадалися, що це таки не він.

Частина лекції була присвячена методам як розпізнавати фейки, але оскільки переважна більшість людей все одно буде бездумно їх поширювати, то просто не бачу сенсу це викладати. На мою думку, проблеми із застосуванням технологій не можна вирішити суто технологіями. Треба змінювати патерни людської поведінки. А про це не йшлося в цій лекції.

Олександра Матвійчук, правозахисниця, голова «Центру громадянських свобод», сторінка у Facebook

Олександра Матвійчук, правозахисниця, голова «Центру громадянських свобод», сторінка у Facebook

Відгуки

Немає відгуків.

Залишити коментар